-

機械学習における新機能

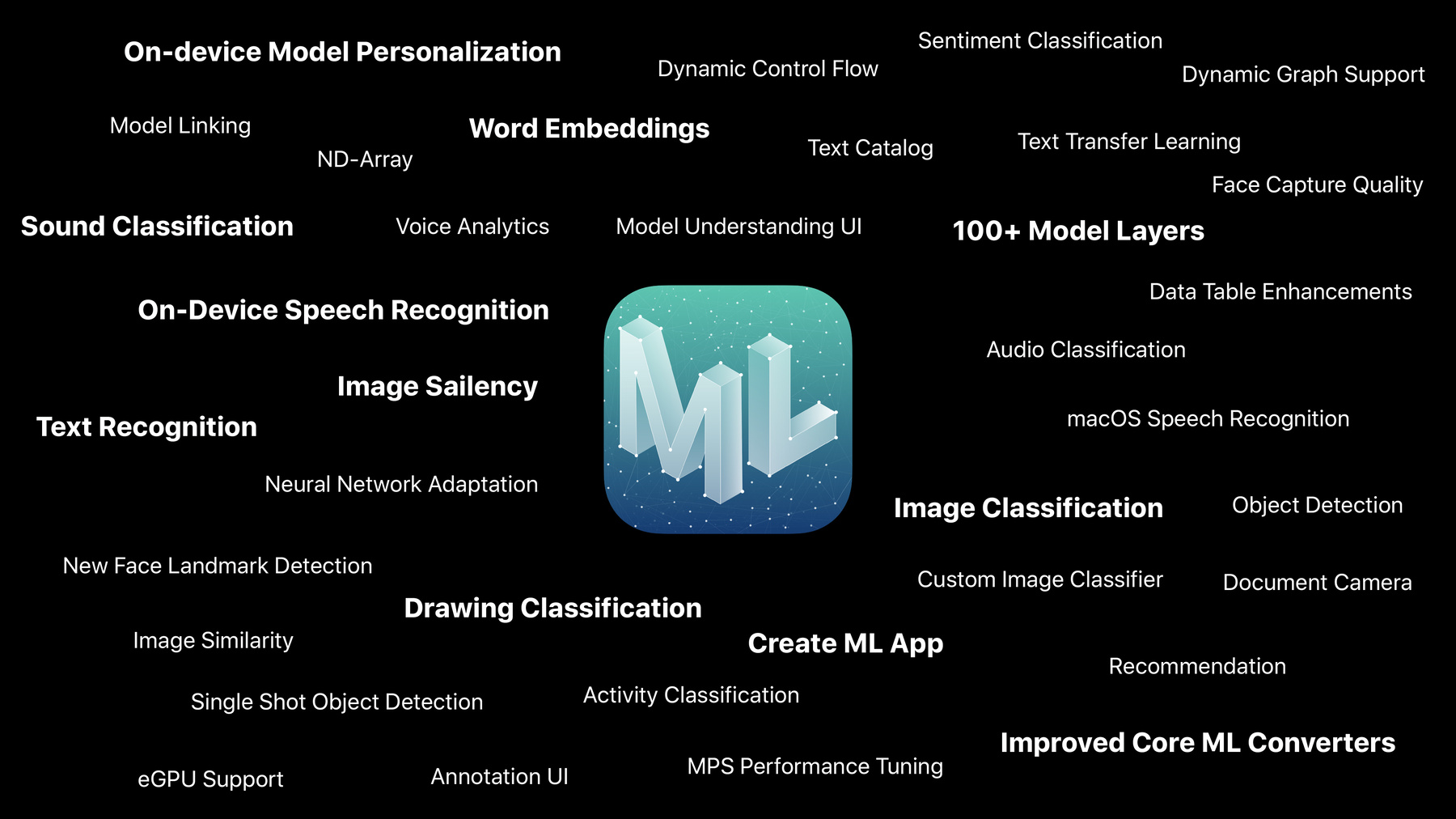

Core ML 3が大幅に拡張され、これまで以上に高度なオンデバイスの機械学習機能をAppで利用できるようになりました。このセッションでは、さまざまなタスクのためのCore MLモデルを簡単に作成できる新しいCreate ML Appについて説明します。Vision、Natural Language、Sound、Speechの魅力的なアップデートや、最先端のモデルタイプに新たに対応したことや、モデルパーソナライズの概要についてご確認ください。

リソース

関連ビデオ

WWDC19

-

このビデオを検索

(音楽)

(拍手)

こんにちは 皆さん ようこそ 私はガウラヴです 今日は機械学習の新機能を 紹介します

機械学習は数多くの Appで使われています 皆さんが作成している Appは最高です ユーザのあらゆる生活面に 関わっています

病院ではリアルタイムで 診断を下すために― Butterfly iQのような Appが使われています

スポーツでは― HomeCourtのようなAppが トレーニングに使われています

クリエイティブな分野では Pixelmator ProのようなAppが― MLを用いてユーザの 創造性を拡張しています これらは ほんの一部です 皆さんにも このようなAppを 作成してほしいと思います

では 新機能を紹介していきます

今日は盛りだくさんです

話すことが多く 1~2セッションでは足りません 全容をお伝えするのに 10セッション必要です

機械学習のデザインに関する― セッションもあります

ラボも毎日開催しています Appleの機械学習エンジニアと 意見を交わす場所です 我々は機械学習を自身のAppに 導入する際に生じる― あらゆる妨げを 取り除こうとしています

どのセッションでも我々は シンプルな原則に従っています 我々の望みは― 機械学習をできるだけ 使いやすくすること

様々なタスクによって 柔軟性を持たせること

そして皆さんのデバイスで 最先端の機械学習モデルを実行させる― 高性能さを持たせることです

機械学習は皆のものです 研究者にも 機械学習の初心者にもです Create ML Appを使って タスクに特化した 最先端のMLモデルを作成できます

次の柱はDomain APIsです

Domain APIsで Appleのビルトインの インテリジェンスやモデルが活用できます データ収集やモデル作成に 悩まずに済みます APIが全てやってくれます

Domain APIsの機能が 今年大幅に拡張されました Vision、Text、Speech and Soundに Domain APIsを追加しました

これらのAPIの実例をいくつか紹介します

まずはVisionです Visionで画像の内容を 判断できるようになります

新機能の1つが イメージサリエンシーです これは画像内の 最も重要な箇所を識別します この場合だと― 人物の周りの部分です

サムネイルの作成や 画像のトリミング メモリーの作成や カメラをガイドしたりできます

他に大きな特徴として テキスト認識もあります

書類の写真を撮ります パースペクティブ補正や 光補正を行い― デバイス上で テキスト認識を行います (拍手) すごいでしょう

でも まだあります 内蔵モデルでの画像識別 人物検出やペット検出があります 詳細は次のVisionの セッションで説明します

次のドメインは Natural Language

さきほどVisionでは 画像から推論を行なった様に Natural Languageでは テキストから推論を行います

今年は新しく センチメント分析を搭載しました テキストに込められた 感情の分析を― デバイス上でリアルタイムに プライバシーに配慮しながら行えます “最終話は興奮した”と 誰かがタイプしたとします これはポジティブな感情です “ラストシーンはガッカリ” これはネガティブな感情です

このようにリアルタイムでの フィードバックが可能です

今回 初めて 単語埋め込み を搭載しました 意味が似た言葉を 探すことができます 例えば“雷雨”という語は “曇り”と関連があります “靴” とか "ブーツ" とは類似していません セマンティック検索が 1つの主要な活用例ですが

Advances in Natural Language Framework セッションで詳細をお伝えします

ユーザーがAppとインタラクションを行う 3つ目の方法はSpeech and Soundです デバイス上で スピーチを文字に起こすサービスで ネットワーク接続に 頼る必要がなくなりました Voice Analytics APIも 新しく搭載しました 内容に加えて “どう話されたか”も認識できます 普通の声と いらだった声を 区別できます

最新のSound Analysisフレームワークは CreateMLセッションで紹介します

各ドメインにはまだ多くの 特徴がありますが 加えて それらをシームレスに 結びつけることが可能です 一例をお見せします

画像をセマンティック検索する 機能を搭載するとしましょう とても複雑な機能です “雷雨”と検索した際に 結果に“雷雨”だけでなく “空”や“曇り”表す画像も 表示させたいとします

VisionとNatural Languageを 組み合わせて― 数行のコードで 実装できるのです 実際にやってみましょう 画像分類を行う時に

内蔵の分類機を使って タグを付ける事ができます

ユーザが“雷雨”と打ち込みます 単語埋め込み を使って 類似した語を推論し- タグに合致した 画像を見つけ出します

まだあります Domain APIとCreate MLを使って作成した 各カスタムモデルを組み合わせることもできます Creating Great Apps Using Core ML and ARKitの セッションで― 実践例をお伝えします

まとめると Domain APIsで Appleのビルトインの インテリジェンスやモデルが活用できるので データ収集もモデル作成も 不要です Vision、 Natural Language そして― Speech and Soundにおいて 大幅に機能が拡張しました

Core ML 3の話に移ります 本日3つ目の柱です

Core MLは Appleの全ての プラットフォームで使えるようになりました

全ての作業がデバイス上で行われるので プライバシーは維持されます Core MLはハードウェア アクセラレータをつかうため リアルタイムでの機械学習に 利用できます サーバーを必要とせず いつでも使えます

Core MLは常に機械学習の 幅広いモデルに対応しています 古典的な一般線形モデルや ツリーアンサンブル サポートベクターマシン 畳み込みニューラルネットワークや 再帰型ニューラルネットワークもです

そして新しい点はモデルの柔軟性と パーソナライズ化です どういうものか見てみましょう

拡張されたCore MLではデータニューラル ネットワークがサポートされています そして 我々は― 100を超えるニューラルネットワーク レイヤを追加しました

ほとんどの最先端の機械学習モデルを Appに搭載できるということです ELMoやBERT Wavenetなどをです これは何を意味するか?

自分のAppに最先端の Q&Aシステムを搭載したいとします “今年のWWDCは 何セッションある?”と聞きます BERTモデルを使うことで 可能になります モデルは音声を分析し― “100以上です”と返答します

Visionにおける 最新機能である 輪郭検出やー オーディオ生成の 最新機能も利用できます

Core MLの拡張サポートを 最大限活用するため―

コンバータをアップデートします 新しいTensorFlowの Core ML コンバータや― ONNX対応MLコンバータを 近日中に公開します

モデルギャラリーのアップデートも 進行中です リサーチモデルを いくつか取り入れたので すぐに使用開始することができます Core ML 3の新しいモデルと組み込みの コンバーター、モデルギャラリーは 最先端のMLリサーチを Appに組み込むために役立ちます 続いてパーソナライズ化に ついてです 概要を説明します これまではCreate MLで モデルを作成し― Core MLで モデルをデプロイしてきました Core ML 3ではオンデバイスの パーソナライズ化が可能です デバイス上でモデルを 微調整できます

FaceIDやWatchFaceの設定などにも 使われる技術です

仕組みを説明します ここにデータがあります MLモデルを作成します

Appに搭載すると― Appユーザは 同じモデルをダウンロードします

素晴らしいことに― ユーザーは写真をアップロードする 必要がないのです 写真を撮り デバイス上のモデルを使って 写っているのが“犬”と 推論することができるのです

思い浮かぶものがユーザごとに 異なる場合はどうでしょう? “私の犬”というコンセプト で考えてみましょう 写真のライブラリでユーザの飼い犬の写真だけを 見つけたいとします

でも各ユーザーの飼い犬は それぞれ違うのです ある人にとっては ゴールデンレトリバー

別の人にはブルドッグ これは私の愛犬です

どうすればいいのでしょう? ユーザ1には 画像識別を使用して― “私の犬”だと認識させます ユーザ2にはブルドッグ 私には この犬

これを実行するための 1つのアプローチとして― サーバーベース方式が あります

各ユーザに写真の アップロードを要求します

サーバーはモデルを生成し ユーザに送り返します

残念なことに これだと プライバシー面の懸念があります サーバーに写真を アップロードするのを― よく思わないユーザもいるでしょう あなたもそれを 望まないかもしれません サーバーの設置には コストがかかります

ユーザ数を100万人として… そうあってほしいですが 100万のモデルを作成し 動向を追う必要があります

Core ML 3では デバイス上での パーソナライズ化が可能です

トレーニングデータがあれば― Core ML3を使って デバイス上で微調整できます

以前はLMHを用いて 推論を行っていました これからは― ユーザーからのラベルデータの反応を見て トレーニングデータを提供し― デバイス上で モデルの微調整を行えます (拍手)

ユーザごとのパーソナライズされた モデルを持てます

ユーザのプライバシーを尊重し サーバー設置は不要です

Core ML 3は ニューラルネットワークの― オンデバイスのパーソナライズ化と Nearest Neighborをサポートします これは夜間にバックグラウンドで処理可能です

最後に今日のまとめをします MLモデルを作成する 新しいCreate ML 大幅に拡張したDomain API オンデバイスのパーソナライズ化を 可能にするCore ML 3

詳細はデベロッパWebサイト セッション209で確認できます

みなさんも私達と同じくらい このテクノロジーについて 心躍らせているとうれしいです ラボで会いましょう ありがとうございました (拍手)

-