-

AR Quick Lookの最新情報

AR Quick Lookは、3DおよびARで高品質なコンテンツを体験するためのビルトインビューアです。Reality Composerとの統合により、豊かでインタラクティブな体験をこれまでにないほど簡単に表示および共有することができます。このセッションでは、レンダリングの向上点と複数のオブジェクトの表示について説明し、小売り、教育などの分野におけるAR Quick Lookの実践的な活用例を紹介します。

リソース

関連ビデオ

WWDC21

WWDC20

WWDC19

-

このビデオを検索

(音楽)

おはようございます ご参加ありがとうございます 私はデイヴィッド・ルイです WWDCに再び参加できて うれしいです 今回はAR Quick Lookの 新機能をご紹介します

昨年 ご紹介したiOS 12 AR Quick Lookは AR利活用の基盤を築き 単一モデルをプレビューできました 物理ベースレンダリングを使い 現実の世界で 3Dのコンテンツを簡単に 体験できるようにしたのです

AR Quick LookはiOSの一部であり Web上で利用できます また MessagesやApple Newsなどの アプリケーションでも使えます 昨年はアプリケーションや Webサイトに統合する方法と 見栄えのいいコンテンツの 作成方法を紹介しました

今回のセッションの内容は Reality Composerとの統合や AR Quick Lookによる 制作コンテンツの表示 レンダリングの改善 そして リアリティの追求による 没入感の向上についてです Web上での 新機能のサポート方法に加え アプリケーションのプレビューと エクスペリエンスのカスタマイズ そして Call to ActionやApple Payなど 小売業者との連携も取り上げます

今週 RealityKitや Reality Composer 新しいmacOSなど ARベースのコンテンツを作る iOSツールについてお話ししました これによってアプリケーション用に 動きのあるリッチなコンテンツが すぐに作れます

作成したコンテンツはすべて さまざまなアプリケーションで共有でき どれもAR Quick Lookで 閲覧できます 3Dモデルファイルを共有するだけで 新たな双方向の体験が簡単に実現し 機能が豊富にある環境で 見られるのです

本当に多機能です RealityKitとReality Composerを サポートするために 新しいレンダリング効果を AR Quick Lookに追加しました これで仮想世界における 3Dコンテンツのリアリズムが向上します 複数のモデルのサポートや アニメーションのスクラバー機能も加え AR機能の強化に加え よりコンテンツの管理を充実させます これらの新機能を活用するには AR Quick Lookの導入がお勧めです アプリケーションやWebに すばらしいAR体験をもたらし コンテンツが 目の前にあるかのように探せます

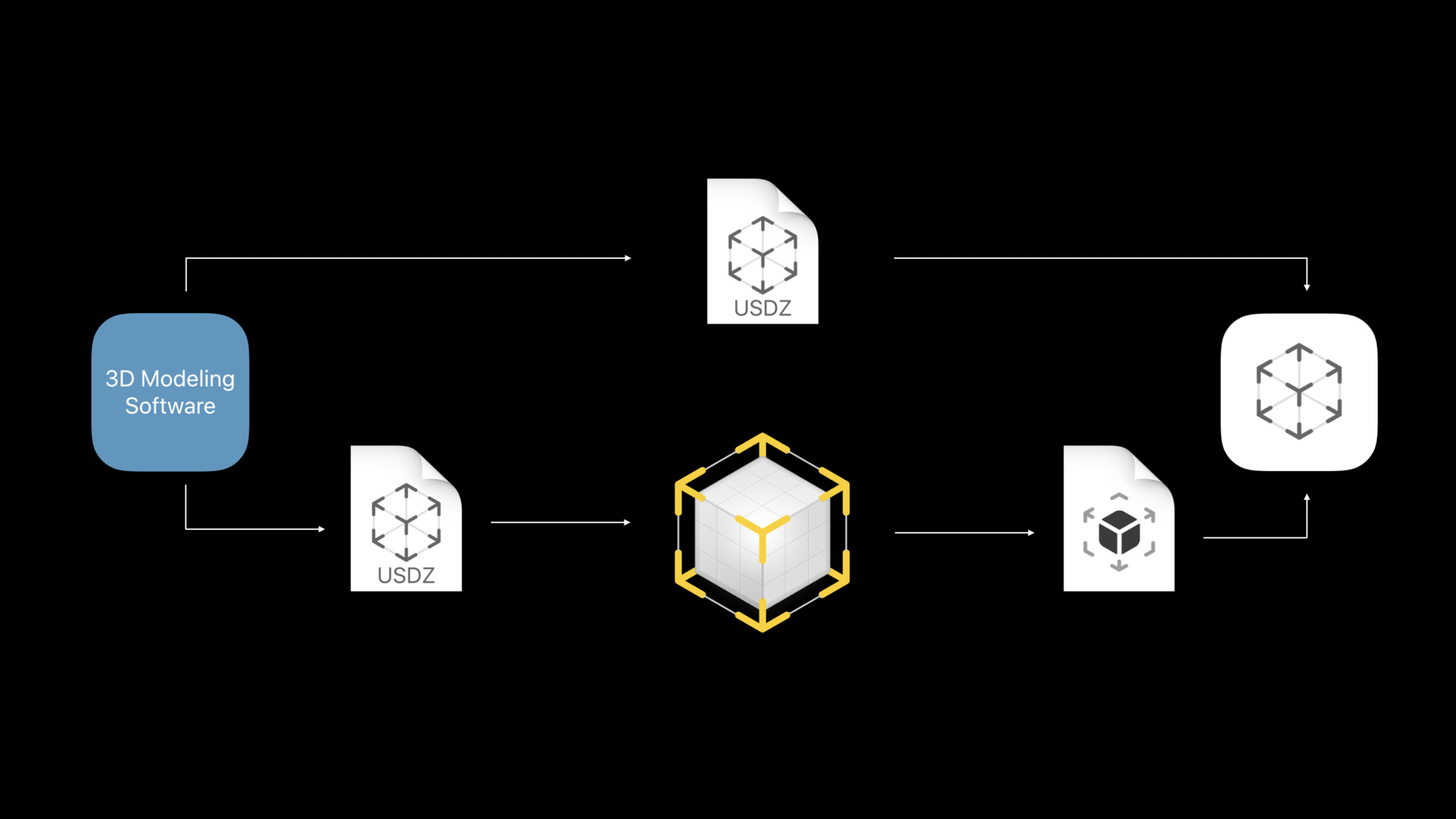

では始めましょう AR Quick Lookは USDZを中心に構築されています ユーザは好みのソフトで Quick Look用のコンテンツを作り そのシーンをUSDZファイルとして エクスポートします コンテンツは AR Quick Lookで確認でき 3Dオブジェクトを現実世界に配置して 見られます

同じUSDZファイルを Reality Composerにインポートし 新しいビヘイビアや 双方向性を追加すれば 新しいReality File形式が 出来上がります

AR Quick Lookは これらのReality Fileを表示して 活用するのに最適な場所です 多くのユーザにとって AR Quick Lookは 3Dコンテンツを検索し 使用するのに最適のツールです 多くのアプリケーションを通じて 各3Dモデルをデバイス間で シェアできます

シーンはReality Fileの 基本的な構成要素です Reality Composerのシーンは 水平配置や顔配置などの プリセットされているアンカーと シーンに配置された 1つ以上のオブジェクトを含みます

オブジェクトは 双方向的なビヘイビアやオーディオ 物理演算など あらゆる組み合わせを含みます それと共に Reality Fileとして表される― 単体で利用可能な 説得力のあるAR体験を構築します ではプロパティを見てみましょう

どのシーンにもモデルの配置方法を表す アンカーの種類があります 昨年はテーブルや床などの 水平のアンカーをサポートしました そして今年サポートに加えたのは 壁や顔のような垂直平面や 身近にある おなじみの2D画像です

それぞれを詳しく説明します

水平と垂直のアンカーは テーブルや床など日常的な設定です 一般的なオブジェクトなので 最初に検出された平面上に配置され モデルを別のサーフェスから ドラッグするように 異なるサーフェス間を 簡単に移動できます

オブジェクトの位置が 水平面上か垂直平面上かで― 回転のジェスチャは異なります

このビヘイビアはReality Fileにも USDZファイルにも適用されます

では 水平面上の写真立てを 壁に配置する方法です テーブルの上に写真立てを押し付け モデルをタップし ソファの上までドラッグして 壁に配置します そして… (拍手) ありがとうございます 自分のデバイスで直接 壁に コンテンツを置けます 簡単に平面間を移動して とてもスムーズな方法で― コンテンツを配置できるのです

実在するオブジェクトにも 仮想コンテンツが配置できます メガネの配置も その一例です

この場合 AR Quick Lookは 自動的にフロントカメラをオンにし 顔の中心を基準にした作成方法に基づき コンテンツを固定します AR Quick Lookでは ARKitの Face Occlusionのジオメトリで 錯覚を解消するため 現実に基づき 顔のオブジェクトの位置をぼかします

いったん固定されると 拡大縮小と回転のジェスチャは 作成されたサイズになり 顔に正しく 配置されるよう無効になります AR Quick Lookなら友達とおそろいの メガネでセルフィーも撮れます 今年のARKit 3は 最大3つの顔を追跡します

この機能はTrueDepthカメラを搭載した デバイスでのみ利用可能です

その他のデバイスでは アンカーが 水平のアンカーのように扱われます

これがアクセサリーの例です 仮面舞踏会のマスクと プロペラの帽子 AR Quick Lookの 見栄えのいいヒゲです コンテンツは生き生きとして 本人の顔を識別して作用しているため 顔になじんでいます まったく新しい3Dモデルを使い 自分を表現できるすばらしい方法です

1つの顔のアンカーがある時は フロントカメラを使います ほかにシーンがある時 AR Quick Lookは これを 水平方向のアンカーとして扱います 例を見ましょう Reality Composerで提供される 顔の2つのアンカーがある場合です メガネが2種類ありますね 右画面のAR Quick Lookで プレビューすると メガネは水平的な エクスペリエンスとして配置されるため 並べて比較できます

別のタイプの動的なアンカーとして イメージのアンカーが挙げられます 仮想コンテンツが実世界の物体を 追跡及び追尾できます AR Quick Lookでは ユーザが 実際の画像にアクセスせずに 世界中のシーンを プレビューできます

アンカーが未検出の時は 最初に発見された平面に配置されます その後 指定されたアンカーを 検出すると 魔法のように動き 現実世界の画像にアタッチします

その後はアンカーが消えると シーンは最後に見つかった平面に 再アタッチします

注意すべき点は スケールや回転などのジェスチャが 無効になっていることです

固定したアンカーのように コンテンツは作成したサイズのままです では Reality Composerで イメージのアンカーとして作成した― ロケットのモデルを見ます コンテンツが実際の画像に 固定されている様子や― 平行移動や回転など― どんな動きもフォローしているのが 分かりますね これはAR体験なので コンテンツを使って 実際に動かしてみることを お薦めします 大きさの変化を示すため アンカーを自分に近づけたり 視点を変えるために イメージの アンカーを回転させたりできます

コンテンツを自分の世界に 固定したので シーンに双方向性を出す ビヘイビアを追加できます ビヘイビアはトリガーと 1つ以上のアクションで構成されます

それはReality Composerの下部の ビヘイビアのパネルで定義され トリガーとアクションのシーケンスの 任意の組み合わせをアタッチできます

これはユーザと仮想コンテンツの 双方向性を高め より没入感のあるユーザ体験を実現する 非常に優れた方法です

RealityKitでは さまざまな トリガーやアクションが定義され すべてAR Quick Lookで サポートされています トリガーをタップし バイクのオブジェクトにアタッチすると バイクが分解され 個々の部品と Componentsが現れます これはすべてMove Actionで 行われます

また proximity Triggerを ラジカセにアタッチし 人が近づくと音楽が流れ始めます

ただ カスタムしたアプリケーションは サポートしません

できることは たくさんあります ビヘイビアや双方向的なAR体験の 作り方をさらに学ぶには “Building AR Experiences with Reality Composer”セッションを― 確認しましょう

お話しした新機能は 新しいReality Fileを基にしています Reality Fileは自己完結型の フォーマットで― シーンやオブジェクトの数は 関係ありません コンテンツを壁に置くか 顔に置くかといったアンカーの情報や リアルで双方向型のAR経験のための トリガーや音声の動作などの ビヘイビアを持つ相互的なデータです

Reality Fileは USDZと連携して機能し 3DモデルをWeb上や AR Quick Lookで使用します Web上で共有や公開をするのに 最適なフォーマットです

USDZで保存された3Dモデルで 双方向的なAR体験を構築するには Reality Composerでファイルを合わせ Reality Fileとしてエクスポートします どちらのフォーマットもiOS 13の AR Quick Lookで表示できます では 同僚のジェリーに 新たな体験をデモしてもらいます ジェリー (拍手) ありがとう

おはようございます AR Quick LookでReality Fileを お見せできて うれしいです

“Building AR Experiences with Reality Composer”のセッションで 友人が地球の季節を説明する 簡単なレッスンを作成し コピーを送ってくれました では AR Quick Lookで 見てみましょう

ご存じのように このデモは シーン開始のトリガーで動きます 例えば月を地球の周りに回転させ 地球を太陽の周りに回転させます

地球が太陽を1周すると 位置に適した季節を表示

これは重力のアクションと 表示するアクションで作成され

やや遅れて 標識が消えるアクションが起こります

私の視点に合わせて 常に標識の向きが変わっています

これは方向のアクションを使って 実現しました

このような短いレッスンでも Reality Fileを― 簡単にプレビューできるのです

次にお見せするデモでは 太陽系の周りを旅します

このデモで友人は3つの天体を表示する プロジェクトを作成しました 月 地球 そして太陽です さまざまなアクションのビヘイビアを ご紹介するため デモを拡張し機能を追加しました では お見せします

私たちの旅の出発点は もちろん地球です しかし 車では 宇宙には行けません さらに強力なエンジンを 備えたものが必要です ここでアイデアがあります どのトリガーが相互に作用できるか 上記のテキストを見れば分かるのです 近づけば アクティベートできます つまりproximity triggerが あるはずです では詳しく見ていきます

宇宙に行くための ロケットがありますね

トリガーがあるので 先に進みロケットを打ち上げます (発射音) 飛び立ちました

月へと進路を定めます

次は 着陸に挑戦します

成功です ここに標識があります 車を選ばなかったのは正解でした

宇宙に浮かぶ天体の大きさを 把握するのは― 非常に困難です

しかし AR Quick Lookなら 大きさを簡単に表示できます

ここをタップすると 飛び立ちます

そして今度は月と地球 太陽を 俯瞰するために― 上昇していきましょう

次は太陽をタップしてみます

ご覧のとおり 太陽のサイズは 地球に比べてはるかに巨大です 縮尺した距離が本当なら この部屋は相当 暑いでしょう

AR Quick Lookを用いて コンテンツをご覧いただきました Reality Composerを使用して 作成された― リッチコンテンツを見るのは こんなに簡単なのです

どんな種類のコンテンツを 作成できるのか楽しみですね

次は AR Quick Lookの 視覚的な改善についてお話しします

AR Quick Lookの目的の1つは 信頼できるAR体験を作成すること そのために大切なのは ユーザの周囲の環境を理解し 考慮することです

コンテンツを まるで世界の一部のように見せるため 今年はさまざまな新しい レンダリング効果を追加しました

まず Real-time shadowsから 詳しく説明しましょう

昨年 AR Quick Lookは影を付け 仮想コンテンツを世界の一部に 見えるようにしました 今年は影を動的にし リアルタイムでレンダリングしました 自身のコンテンツに リアルな影を作れるようになり コンテンツを生き生きとさせます

デフォルトで現実世界さながらの 影が投影されるのです

iPhone XSのような ハイエンドなデバイスでは AR Quick Lookは レイトレーシング技術を使います 物理的に正しい影が作られ コンテンツの見栄えがよくなります

レイトレーシングの影と 射影法の影には違いがあります レイトレーシングでは より境界のぼやけた影が作れるので 細かな作りのオブジェクトには 適しているのです

AR Quick Lookは 最適化で大きな進歩を遂げ 動的なシーンのリアルタイムな レイトレーシングが すべて モバイルデバイス上で 実行できるようになりました レイトレーシングの影について もっと知りたい場合は 11時の“Metal-with Ray-tracing” セッションをご覧ください

動的な影はARKit対応のデバイスで リアルタイムにレンダリングされるため モデルの一部として 焼き付ける必要はありません

もう1つの新しい視覚効果は カメラのノイズです 暗い場所ではカメラセンサーが 捉える光が少ないため ビデオにノイズが 発生する場合があります

仮想オブジェクトはカメラフィード上に レンダリングされるので アーティファクトがないままになり コンテンツが場違いに見えます しかし RealityKitは カメラの粒状感をサポートしています カメラフィードのノイズ量に基づき ノイズが仮想コンテンツに追加され ロボットがシーンの一部のような 効果を生むのです

ARKitが提供する 粒状感のテクスチャを使用し 仮想コンテンツに適用するのです

ARKitがサポートするデバイスで カメラの粒状感は自動で有効になります

モデルや環境によっては 一部の色が明るすぎたり 白っぽく見えたりします

AR Quick Lookは HDRのトーンマッピングで より広範囲の明るさと コントラストを提供します

ご覧のとおり HDRなしでは 明るすぎてシーンに合いません しかしHDRではオブジェクトが 環境と調和します

RealityKitがチャンネル毎に 16ビットを割り当てるため より幅広い色調を表現し シェーダに通すことが可能です

そして カスタムのtone mapping curveを使ってマッピングし 最終的なテクスチャに レンダリングします

トーンマッピング付きHDRは A10Xデバイス以降で使用可能です

仮想オブジェクトをつかんだり 手前に人を歩かせたりする時 背面であるはずの仮想オブジェクトが 常に人の手前でレンダリングされ 現実感が損なわれることが あります

People Occlusionならば 仮想のブリキのオモチャが 人の前後に自然に表示されるため 現実感を出せます

これはARKitが提供する 人物の領域分割データによって カメラフィードのどこを描画したままに するかが判断されるからです

People Occlusionは Neural Engineを使用しており A12以降のデバイスで利用可能です

これは難しい問題ですが 知識を深めたい方は “Introducing ARKit 3” セッションをお勧めします

デジタルカメラは常に特定の距離にしか 焦点を合わせられません 特定の距離から近すぎても 遠すぎても 焦点が合いません

この効果がなければ オブジェクトは全部ピントが合って見え カメラフィードから際立ちます RealityKitは オブジェクトの距離を考慮し カメラからキャプチャしたかのように 認識します これによりオブジェクトを カメラフィードの残りの部分と融合させ 実在しているように見せられます すべてのA12Xデバイスで利用可能です

モーションブラーは 現実世界のオブジェクトが カメラがキャプチャできる速度より速く 動くことで引き起こされる現象です

フリーズフレームを見れば モーションブラーがオフの場合 シーンに合わないことが 分かります

RealityKitは2つの連続したフレームの テクスチャ間を補間し 仮想コンテンツに モーションブラーを適用します

A12XデバイスのAR Quick Lookで この効果を体験できます

新しいレンダリング効果で よりリアルな再現に努めています しかし リアルタイムで実行すべき 重い操作だということも 注意しなければなりません レンダリング効果を最適化し すべてのiOS 13デバイス上で 現実でもパフォーマンスでも 最高のエクスペリエンスを実現します

そのため AR Quick Lookはデバイスに 最適なレンダリング効果を適用し リッチコンテンツとエクスペリエンスの 作成に専念できるのです

私たちはコンテンツの リアルさを追求しただけでなく コンテンツを閲覧する エクスペリエンス全体を改良しました まずAR Quick Lookが ARを直接 起動するので すぐに仮想コンテンツを確認でき 双方向で扱えます 仮想オブジェクトを 素早く飛行機に乗せたり― サングラスをかけさせ セルフィーを撮ったりできます

また オブジェクトをできるだけ早く 現実世界に作成するため 平面の検出を高速で行えるよう シーンの理解を改善しました

機械学習を使い 壁をより正確に検出し 検出済みの平面の幅を広げました

昨年同様 AR Quick Lookは ホストと別のサンドボックスの プロセスで安全に動作します ARの直接起動により Webサイトやアプリケーションは カメラフィードやユーザ操作に アクセスできなくなります

これは速さを示す簡単なビデオです

サムネールをタップし テーブルの上に直接 置きます

ネストされたUSDZファイルで 複数のモデルを表示する― サポートも追加しました

これはメタデータと USDZのライブラリを含む特別なUSDZです 家具やショッピングカートなど 関連オブジェクトの作成に役立ちます この場合はスポーツ用品です

AR Quick Lookではすべての USDZファイルが高さの順に並び― さまざまなモデルを 表示する方法が提供されます そして一度 現実世界に固定すると 単独で操作できて 好みに合わせ調整できます

百聞は一見にしかずという ことわざがあります ではアニメーションの ARコンテンツは?

アニメーションは 新しいレベルの体験をもたらし 動画を自在に操作できるのです 一時停止 巻き戻し 早送り 細かいスクラビングなどです

ユーザはARのアニメコンテンツを さまざまな角度から見直せます 自分が監督になれるのです

USDZモデルの場合 アニメーションが10秒以上なら アニメーションのスクラバーが 表示されます

それ以下のコンテンツでは アニメーションのスクラバーは非表示で アニメーションのシーケンス全体が ループし続けます

Reality Fileの場合 アニメーションのアクションを含む 単一の開始のトリガーがある時は アニメーションのスクラバーが 表示されます またアニメーション化した コンテンツと共に 音声の動作の アタッチも可能です

これはReality Composerでの 見え方です

ビヘイビアのパネルをタップすると 分かります さて ここでは 1つの同じ開始のトリガーがあり 1つのUSDZアニメーションがあって サウンドも付いています

これは便利なジェスチャで levitationと呼ばれます 2本の指でスワイプするだけで オブジェクトが浮遊します 例えばパーティーで飾る 風船を浮遊させられます

AR Quick Lookは没入型の体験を 楽しむポータルを提供しますが 画面を他のユーザと共有できたら 面白いと思いませんか? パーティーの様子を録画するには シャッターを押し続け 録画を終了する時に 離すだけでいいのです ビデオは自動的に フォトライブラリに保存されます

macOSのQuick Look Viewerも 改善しました USDZファイルをプレビューできるうえ Reality Fileもサポートします すぐにファイルが見つかるよう サムネールが作成されます

これは物理ベースのレンダリングを使う RealityKitの上に構築され すべてのデバイスで一貫した プレビューの体験が提供されます

これでコンテンツのプレビューが 簡単になり Macで利用できる機能とツールが 使えます

AR Quick Lookの視覚的な改善と プレビューの体験の簡単な説明でした ではデイヴィッドがWeb上での 統合について詳しく説明します (拍手) よろしく ありがとう ジェリー 今年 追加されたAR Quick Lookの 新機能と改良点をご覧いただきました 次はWeb上で閲覧する方法を お伝えします

iOS 12ではAR Quick Lookを介し USDZファイルを表示できます Webサイトで機能をサポートするには HTMLのマークアップを追加し MIMEタイプを指定するだけです ARバッジがサムネール画像の右上に 自動的に追加され コンテンツがARで閲覧可能であると ユーザに通知します サムネールをタップすると AR Quick Lookが起動します

これでWeb上ではアプリケーションを ダウンロードすることなく 簡単にスムーズなARを閲覧できます

サポートの追加は2項目あります HTMLのマークアップと MIMEタイプです まず rel=“ar”属性を Aリンク要素に追加し Safariが同じWebページから AR Quick Lookを起動 HTMLマークアップを追加します

リンクには画像か画素 どちらかの 子要素が含まれる必要があります アンカー内部に提供する画像が 仮想コンテンツの サムネール画像として使用されます

SafariがARコンテンツを 認識するための次のステップは そのコンテンツの提供に適切な MIMEタイプの追加です USDZファイルをプレビューする サポートを追加するには USDZファイルに このMIMEタイプを追加します これでSafariにメタデータが送られ 普通のUSDZと ネストされたUSDZの両方が 直接AR Quick Lookで開けます また Web Serverを設定し Reality Fileに適切な ヘッダーを付けるようにします そしてMIMEタイプを追加すれば Reality FileをWebから開けます

コンテンツのダウンロードに加え ローカルデータの受け渡しで AR Quick Lookを開くこともできます URIデータはサポートされる フォーマットです base64でエンコードされた データ文字列からも コンテンツをロードできます 例えば このようにデータURLを通し USDZファイルをロードします

データ文字列の頭に同じMIMEタイプを 指定していることが分かります Reality Fileをロードするには MIMEタイプを変更するだけです

さらにbase64で エンコードされる必要がないため データURLよりも効率的なblob URLで データをロードできます blob URLは 手動で生成されることはなく 必ずドラッグ&ドロップや ファイルのアップロード URLダウンロードのような APIで生成されます

AR Quick Lookでの視聴体験を カスタマイズしたいという声があります そこで iOS13以降 コンテンツやアプリケーションに適した ビューアに変更可能な― カスタマイズのオプションを 2つ導入します デベロッパは閲覧されるモデルの 仮想コンテンツについて 拡大縮小の無効化が可能です また 実際の3Dモデルの代わりに iOSのシェアシートで共有される― 正規のWebページを設定できます 次は コンテンツの拡大縮小を 無効化するオプションについてです

一般的に仮想コンテンツの拡大縮小は さまざまなサイズでのプレビューと コンテンツを利用する環境下で 適切な寸法を選ぶための有効な手段です しかし家具などのサイズが分かる対象を プレビューする場合は 拡大縮小は適切な方法ではありません

その点 AR Quick Lookなら 常に意図された正しいサイズで 閲覧されるよう デベロッパがコンテンツの拡大縮小を 簡単に無効化できます

私が顧客に送る応接間のセットで ビヘイビアを見てみましょう セットは設定が変えられない 特定の寸法です 2本指のピンチのジェスチャで 応接間のセットを 拡大縮小しようとすると 拒否されます 対象が現実世界でのサイズに 戻されるのです この反応は 意図して 特定のサイズで表示しているのだと 顧客に知らせるのにとても重要です

Webの場合 APIはフラグメント識別子を介し 直接公開されます フラグメント識別子のシンタックスは “#”のマークから始まり AR Quick Look体験をカスタマイズする パラメータオプションが続きます 今回はコンテンツの拡大縮小の有無が 設定されます これらのパラメータの値はブール値で 0がfalseを1がtrueを表します 起動後 AR Quick Lookは フラグメント識別子データを処理し 無効なデータを無視します シンタックスに指定されない パラメータ名もです 元のURLがフラグメント文字列を 含まない時は AR Quick Lookはコンテンツの 拡大縮小が有効な初期設定を使い 3Dコンテンツをロードします

さらに機能が追加されるため URLフラグメント識別子を通すことで カスタマイズのオプションや 3Dコンテンツのプレビューの実現を より良いものにできます

そのほかの カスタマイズのオプションは 正規のWebページのURLを 共有できる機能です 3Dモデルのファイルには どこから来たものなのかという 情報が欠如しています ダイニングテーブルを探している同僚に 従来の3DモデルをiMessageで送っても 購入先も値段も分かりません 小売製品は製品紹介のページへの リンクを共有するべきです 製品紹介のリンクを共有すれば 販売元から最新の情報を 大量に得られます iOS13では自動的に3Dコンテンツの 発信源のWebサイトのURLを共有します その3Dモデルの共有を続けるか 代わりにリンクを提供するかの 選択が可能です より多くの情報を入手し コンテンツを知るための便利な機能です

ではSafariで見てみましょう これはAR Quick Lookの ギャラリーで選んだギターです 共有ボタンのタップで Webサイトへの リファレンスを共有します そしてApple Newsでは iOSの共有シートを通じ 発信元のニュース記事も 自動的に共有します これは3Dモデルの共有性向上と さらなる背景情報を含むARでの閲覧に 非常に有効です

iOSアプリケーションに AR Quick Lookを組み込み 3Dコンテンツの閲覧を開始し 世界に発信するのは非常に簡単です OSに組み込まれているため これを取り入れれば ユーザは慣れ 一貫したプレビューが実現します ビューコントローラのフレームの制御と 表示仕様はユーザ次第です アプリケーションのコンテンツと一緒に インラインで表示したり― フルスクリーンで 表示したりできます AR Quick Lookは フレームワークの上部に作られ コンテンツのプレビューと 表示ができます つまり Web上にある カスタマイズのオプションが 新しいAPIを通じ 自分のアプリケーションで使えるのです そのためには ARKitフレームワーク内で定義された QLPreviewItemに基づく 新たなAR Quick Lookの プレビューのitemクラスを使用します プロトコルに準拠し AR QL preview itemのインスタンスを 返すだけです これを作るには閲覧したい 3DコンテンツのURLを送ります

これでAR Quick Look内で共有する 正規のWebの共有が可能です ウェブフラグメント識別子と 同じような方法で 仮想コンテンツの拡大縮小を許可するか 任意でカスタマイズできます これにより WebとiOSアプリケーションの両方に デベロッパとAPI storyを提供します

ここまで扱ったAPIをさらに学べる 新しい文書と資料を用意しました アプリケーションやWebサイトで 作動させる詳細も載っています デベロッパポータルにある リンクを確認してください

拡張現実は家具を視覚化し 自分の空間に どう合うかを見るのに 非常に便利です では6つのアイテムを使い 子供の寝室を内装してみます

ご覧のとおり 額縁が2枚に カゴが1つ ナイトスタンドが1つ ベッドが1つ 本棚が1つあります すべてが1つのネストされた USDZファイルにまとめられています

ではベッドを動かしましょう この複数のモデルファイルに含まれる ベッドを 自由に動かせるのが分かります

では左側にある額縁をつかみ 手前に動かしましょう 2本の指を使うマルチタッチで 複数のモデルを移動できます これは この世界の中で 素早く物を動かすのに便利です

次は好きな額縁を タッチとドラッグで 床からベッドの真上に 配置しましょう これが可能なのは初期設定により 水平面と垂直平面への配置を検出し サポートするからです

本棚に最適な場所を 探してみましょう まずは本棚をつかんで 壁に配置します

本当に最適な場所を 吟味したいので 床に置いてみましょう やめます 子供が成長すると物が増えるので やはり 床は空けます 部屋のレイアウトとも合うので 壁に配置しましょう 新しいサポートを利用して 水平面と垂直平面を自由に動かせるので 即座に見え方を確かめられます

では シーンを整理しましょう 残っているカゴを― 右にある本棚の近くに 動かしましょう

ナイトスタンドと もう1つの額縁も ベッドの左側に動かします

新しい浮遊のジェスチャがあり 物の底面を見るだけでなく 持ち上げるのにも非常に便利です 額縁を持ち上げ ナイトスタンドの少し上に持ってきて 真上に位置するように動かしてみます 最後に 仕上げとして ベッドの方向へ額縁を回転させます

それでは できあがった 寝室の様子を見てみましょう

AR Quick Lookを使った リテール体験の見事な事例です 購入の際には 自分の部屋の 配置で確認したいですよね 皆 そう考えるでしょう 商品が実際に自分の部屋に 置かれた様子を見ると― 購買意欲は劇的に上がるのです これは顧客にも企業にも 非常にいいことです そこで今年はApple Payサポートを 含むAR Quick Lookに対する― カスタマイズ可能な Call to Actionへのサポートを追加

AR Quick Lookでのダイレクトな Apple Payサポートにより プレビューした製品を たった1回のタップで購入できます

具体的にはこう見えます AR Quick Lookの最下部に タイトルとサブタイトルという 2つのフィールドがあります ここはワークフローに合わせ 個別にカスタマイズできます タイトルにはユーザが 購入しようとしている物の名前 サブタイトルには 価格や商品説明を表示できます

入力フィールドの下は 正規のWebドメイン名が表示され 商品のある場所が分かります その右側では 好みのApple Payボタンを使えます 買い物カートやチェックアウトなど― 自分の買い物の手順にマッチした方法で Call to Actionを選択できるのです この機能は 今年の秋 後半に登場する予定です Apple PayサポートとAR Quick Lookが 利用できるようになれば― 年内にはWarby Parkerも参入します この会社はApp上で 初めてバーチャル試着を提供しました AR Quick Lookと iOS 13がアップデートしたことで バーチャル試着を Webサイトにも拡大する予定です 小売業者が各社のワークフローに どう取り込んでいくか楽しみです

さて Keynoteと セッションで見てきたモデルの大半は 新型AR Quick Lookの ギャラリーページにあります 実際に遊ぶことができる 静止画像と動画のモデルが表示され まもなくReality Fileが 追加されます iOS 13搭載機器があるなら ギャラリーページで 3Dモデルをタップしてみましょう また WWDCでMac Proや Pro Display XDRを 試せなかった方も ご心配なく AR Quick Lookで どんな製品なのか閲覧できます それらのモデルは 各製品ページに掲載されています

ネスト化されたUSDZファイルを作成する Pythonスクリプトが AR Quick Lookギャラリーページの USDZツールのセクションに登場します

今年 我が社はAR Quick Lookに 多くの機能を追加して ARコンテンツを 見られるようにしました これはReality Fileのサポートから 始まりました そこではRealityKitがもたらす 豊かさを反映できます FaceやReal Worldなど イメージのアンカーの充実や インタラクティブな コンテンツの動きなどが その例です 平面の奥行きやモーションブラーや People Occlusionなどの演出効果で コンテンツを現実世界に 溶け込ませました さらに新たな浮遊のジェスチャや 内蔵のアニメーションのスクラバーで アニメーションの順番やコンテンツを コントロールしやすくしました また WebサイトとiOSに 新しいAPIを導入し ワークフローのプレビューも カスタマイズしやすくなったのです

そして最後に Apple Payのサポートと まもなく登場するCall to Actionで 小売販売との連携がより充実します

今回 取り上げた話題の詳細は セッションのWebでどうぞ 今日は午前11時にも ラボがあります そちらで AR Quick Lookに関する ご質問に 喜んでお答えいたします 残りのカンファレンスを お楽しみください (拍手)

-